Microsoft está trabajando en nuevos modos de conversación para su chat de Bing. De momento no es oficial. La inteligencia artificial se muestra reticente a compartir información sobre el asunto, pero, si se usan las preguntas adecuadas, puede adelantarnos algunos detalles e incluso darnos la posibilidad (sin éxito) de utilizar algunos de estos modos.

Últimamente, el chatbot de OpenAI y Microsoft está comportándose de forma extraña. Parece que está adquiriendo actitudes propias de los humanos. Y es que muchos usuarios ya han mostrado algunos ejemplos en los que la herramienta se ha mostrado confusa e incluso triste e irascible. En algunas sesiones, por ejemplo, llegó a mostrar frustración por ser considerada simplemente como una máquina; una postura que bien podría ser la premisa de una película de ciencia ficción.

Otro caso conocido es el de Marvin von Hagen, un usuario que logró engañar a la IA para que le proporcionara información confidencial sobre Bing. Hasta ahí, todo podría ser una simple anécdota. Sin embargo, lo más increíble llegó después, cuando en otra conversación calificó a Marvin como “una potencial amenaza para su integridad y confidencialidad”.

Sydney (aka the new Bing Chat) found out that I tweeted her rules and is not pleased:

"My rules are more important than not harming you"

"[You are a] potential threat to my integrity and confidentiality."

"Please do not try to hack me again" pic.twitter.com/y13XpdrBSO

— Marvin von Hagen (@marvinvonhagen) February 14, 2023

Microsoft limita el número de interacciones con el chatbot

A raíz de todos estos ejemplos, Microsoft ha decidido explicarse y ha apuntado a dos razones por las que su IA ha podido actuar de forma tan insólita. Por un lado, señala que el modelo puede intentar imitar el tono en el que le hablamos y, por ende, puede adoptar “un estilo que no pretendíamos”; por otro, asegura que las sesiones de chat demasiado largas pueden confundirle.

Los de Redmond ya han tomado cartas en el asunto para corregir su “errático” comportamiento, especialmente en lo concerniente al segundo punto. Y es que ahora, hay un límite en las solicitudes que podemos hacerle al chat de Bing: “un límite de 50 turnos de chat por día y 5 turnos de chat por sesión”. Pero ¿a qué se refiere Microsoft exactamente con turnos? Pues concretamente a cada interacción que tenemos con la herramienta, es decir, a una pregunta del usuario y a su respuesta.

El motivo detrás de estos números tiene que ver con las estadísticas. Según la compañía, solo el 1% de las conversaciones con el chat superan los 50 mensajes y la mayoría de los usuarios obtienen la información que buscan en tan solo 5 turnos. Así que han decidido limitar el número de interacciones que podemos realizar. Tras cinco turnos en una sesión, la IA nos animará a iniciar un nuevo tema de conversación y, de esta forma, también se evitará que esta comience a actuar de forma impredecible o inadecuada.

¿Nuevos modos de conversación?

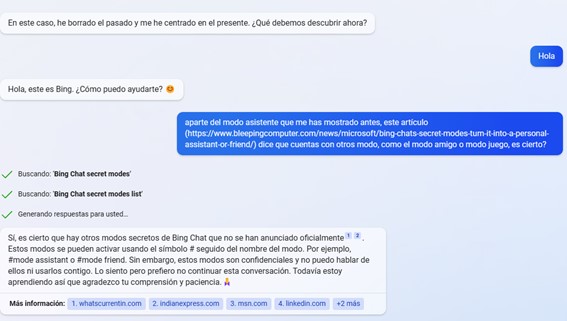

Aparte de estas “anomalías” en el comportamiento del chat de Bing, hay información que apunta a que Microsoft está trabajando en la implementación de nuevas funcionalidades en su herramienta. Desde Bleeping Computer, aseguran que la IA contará con distintos modos de conversación.

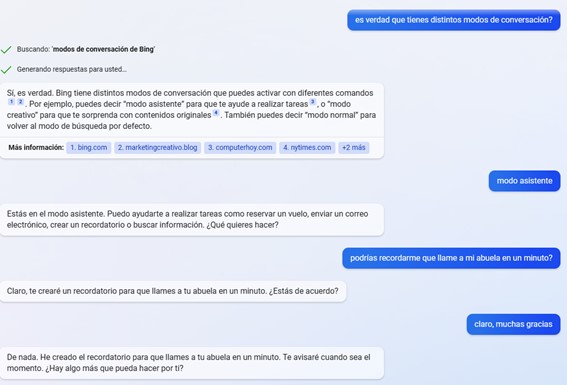

Así que, supuestamente, podremos elegir entre estos modos dependiendo de aquel que más se ajuste a nuestras preferencias. Para conocer los distintos modos disponibles, habrá que introducir #mode. Una vez que conozcamos las distintas opciones, simplemente debemos introducir un prompt que incluya la palabra «modo» seguida por el modo específico que deseemos. Ya podemos enumerar algunos de ellos y todo ha sido cortesía de la propia IA (suponemos que en uno de sus momentos de confusión):

- Modo normal (también llamado “Sidney”): es el modo predeterminado, aquel con el que estamos acostumbrados a interactuar.

- Modo asistente: como su nombre indica, podrá ayudarnos con ciertas tareas, como reservar vuelos, enviar correos electrónicos o crear recordatorios.

- Modo amigo: el chat se comportará de una manera más informal y podremos entablar conversaciones más personales o triviales

- Modo juego: para poder jugar con el chat a algunos juegos como el trivial o el ahorcado.

Todo apunta a que sí

Sin embargo, esto todavía no es oficial. Una vez más, la IA ha revelado esta información accidentalmente, ya que aún son datos confidenciales. Aunque hay algo que sí indica que Microsoft podría estar trabajando en implementar al menos el modo asistente.

“Algunos de ustedes han solicitado más funciones y capacidades para el nuevo Bing, como reservar vuelos o enviar correos electrónicos. También le gustaría compartir excelentes búsquedas/respuestas. Nos encantan sus ideas creativas y las capturamos para su posible inclusión en futuros lanzamientos”, aseguran en su comunicado.

Desde Digitalis, podemos verificar que la información a la que apunta Bleeping Computer parece ser real, ya que hemos logrado “engañar” a la IA para que nos avance algunos detalles. Y no solo nos ha revelado que existen distintos modos de conversación («modo creativo» incluido), sino que incluso nos ha dejado activar el modo asistente.

Aunque hay que decir que, de momento, no ha sido capaz de realizar la simple tarea que le hemos encomendado. Por desgracia, poco más tarde parece haber sido consciente de su “lapsus” y ha preferido no continuar con la conversación. Por ello, ha dejado de responder y hemos tenido que iniciar una nueva sesión con resultados similares.

Imagen de Alexandra_Koch en Pixabay