Apple retrasa el lanzamiento del plan de seguridad infantil mediante el cual planea escanear los iPhones en búsqueda de imágenes de explotación infantil.

A principios del mes de agosto, la compañía de la manzana anunció un nuevo plan de seguridad infantil para sus dispositivos que implicaba tomar ‘hashes‘ (una especie de huella digital) de las imágenes cargadas a iCloud y compararlas con una base de datos que a su vez contiene hashes de imágenes CSAM (material sobre abuso sexual infantil) conocidas. Estaba previsto que el nuevo plan de seguridad se lanzara a finales de este año.

Reconsideración tras las críticas

Tras el anuncio de su nuevo plan de seguridad, Apple recibió críticas generalizadas de grupos de privacidad y otros, preocupados de que el seguimiento en el dispositivo sentase un precedente peligroso. Según informa BBC, la compañía indicó que había escuchado los comentarios negativos y está reconsiderando su plan de seguridad.

Tras el anuncio de los planes de la compañía, existía la preocupación de que los estados autoritarios pudieran abusar del sistema. La llamada tecnología NeuralHash habría escaneado imágenes justo antes de que se cargaran en iCloud. Luego, los habría comparado con material conocido de abuso sexual infantil en una base de datos mantenida por el Centro Nacional para Niños Desaparecidos y Explotados.

«El mes pasado anunciamos planes para funciones destinadas a ayudar a proteger a los niños de los depredadores que usan herramientas de comunicación para reclutarlos y explotarlos, y limitar la difusión de material de abuso sexual infantil«, indicó Apple en un comunicado enviado a The Verge. «Basándonos en los comentarios de los clientes, grupos de defensa, investigadores y otros, hemos decidido tomarnos más tiempo durante los próximos meses para recopilar información y realizar mejoras antes de lanzar estas características de seguridad infantil de importancia crítica».

La Electronic Frontiers Foundation (EFF), organización desde la que afirman defender las libertades civiles de los usuarios en el mundo digital, ha sido uno de los críticos más acérrimos del sistema, reuniendo una petición firmada por 25.000 clientes que se oponen a la medida.

Apple's filtering of iMessage and iCloud is not a slippery slope to backdoors that suppress speech and make our communications less secure. We’re already there: this is a fully-built system just waiting for external pressure to make the slightest change. https://t.co/f2nv062t2n

— EFF (@EFF) August 5, 2021

El plan de seguridad de Apple

Al comparar únicamente la huella digital de las imágenes cargadas a iCloud con los hashes de imágenes CSAM, Apple sería capaz de mantener los datos de los usuarios encriptados y ejecutar el análisis en el dispositivo. De encontrarse una coincidencia, un humano la habría revisado manualmente y, de ser necesario, se habrían tomado las medidas necesarias para deshabilitar la cuenta de un usuario y denunciarlo a las autoridades.

«En Apple, nuestro objetivo es crear tecnología que empodere a las personas y enriquezca sus vidas, al mismo tiempo que las ayuda a mantenerse seguras«, afirmaba la compañía en el anuncio de su nuevo plan de seguridad. «Queremos ayudar a proteger a los niños de los depredadores que utilizan herramientas de comunicación para reclutarlos y explotarlos, y limitar la propagación del material de abuso sexual infantil (CSAM)».

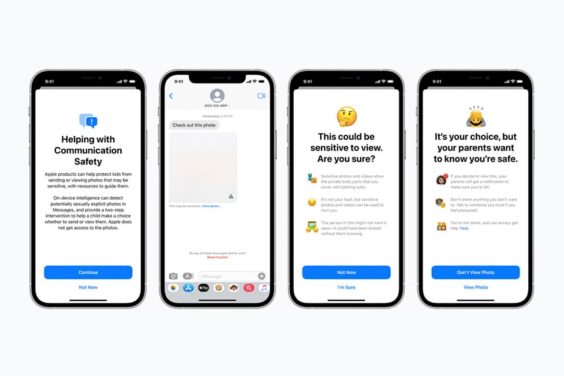

La compañía también está ampliando la ayuda disponible a través de Siri y Search al proporcionar recursos adicionales para ayudar tanto a niños como a padres a mantenerse seguros en línea y obtener ayuda en situaciones inseguras. Por ejemplo, los usuarios que pregunten a Siri cómo pueden denunciar el abuso sexual infantil o la explotación infantil serán dirigidos a recursos sobre dónde y cómo presentar una denuncia.

Otro aspecto de la nueva estrategia de seguridad infantil de Apple consiste en advertir opcionalmente a los padres en el caso de que su hijo menor de 13 años envíe o vea imágenes con contenido sexualmente explícito. Un memorando interno de la compañía reconoció que la gente estaría «preocupada por las implicaciones» de los sistemas.